Почему ваш сайт не индексируется: разбираем 5 основных ситуаций

- Индексируется или нет?

- Ситуация 1. Сайт закрыт для поисковика

- Ситуация 2. Роботы не знают о том, что вы такой красивый есть в сети

- Ситуация 3. Бан

- Ситуация 4. Технические недочеты

- Ситуация 5. Очень плохое качество страниц

Индексируется или нет?

Первым делом - убедимся в точном наличии проблемы. Пробуем проиндексироваться.

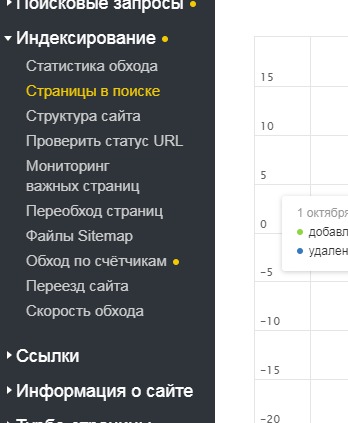

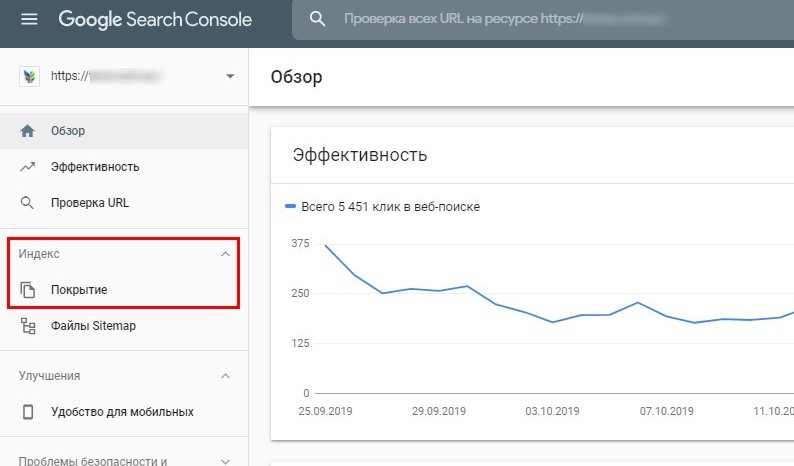

Нам в помощь Google Search Console и Яндекс.Вебмастер

Яндекс.Вебмастер -> Индексирование -> Страницы в поиске.

GSC -> Индекс -> Покрытие

Внимательно смотрим последние манипуляции с индексами страниц, мониторим историю и понимаем - работает ли на нас поисковый робот. Если информация устарела - поздравляю. Вам не казалось и теперь будем решать вопрос!

Поисковый оператор нам в помощь.

Выглядит оператор как “site:<ваш url>”

В Гугл:

В Яндексе:

Разница в результатах небольшая и некритичная, а значит сами поисковые боты сайт видят и учитывают. И это хорошая ситуация

Если ситуация вышла НЕхорошая и результаты поиска оператора либо отсутствуют либо они сильно разнятся - значит самое время разбираться почему так произошло.

Ситуация 1. Сайт закрыт для поисковика

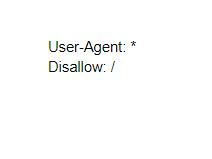

Самый вероятный вариант - это строки в файле robots.txt

При таком тексте сайт будет наглухо закрыт для поисковиков. Удаляем строчку Disallow: / и готово.

Другие варианты недоступности для роботов:

Домен неделегирован (этот момент внимательно разбирают те, чьи домены уже имеют какую-либо сетевую историю)

Криво поставлен тег noindex - в результате были спрятаны и нужные и ненужные страницы

Индексирование закрыто в самой админке CMS

Индексирование закрыто в файле .htaccess

Ситуация 2. Роботы не знают о том, что вы такой красивый есть в сети

Такое обычно бывает с юными доменами. Если вы открылись совсем недавно - возможно это ваша ситуация. Совершив все нужные действия в Google Search Console или Яндекс Вебмастере, ждем как минимум две недели индексации сайта в ПС.

Либо сведений и ссылок на ресурс настолько мало, что вы буквально невидимка. Лечим это перелинковкой при создании новых страниц и ссылками с крупных-серьезных сайтов.

Ситуация 3. Бан

Если вы внезапно проштрафились перед Гуглом или Яндексом за различные “поисковые правонарушения” - сайт попадет в список неблагонадежных и роботы на индексацию к вам в гости не придут.

Эта ситуация, помимо прочего, плоха своей неочевидностью. Яндекс.Вебмастер еще может вас уведомить о наложенных санкциях и намекнет на исправление ситуации. Google же так просто разобраться в случившемся не позволит. Скорее всего - потребуется помощь грамотного SEO-специалиста.

Из-за чего бывают санкционные фильтры:

Некачественное и нерелевантное контент-наполнение

Раздражающая реклама

Торговля ссылками и link-spam

Семантическое ядро с заспамленными ключами

Вредоносный код

Накрутка кликов

Признание аффилиатом

Ситуация 4. Технические недочеты

Мелкие технические недочеты могут привести к большим проблемам в индексации. К счастью - это настолько же легко исправимо. Проверяйте:

Ошибочные http-заголовки

Плохие редиректы (302 вместо 301, rel=”canonical” с одной и той же канонической страницей для всего)

Ошибочно выбранная кодировка

Банальные ошибки сканирования, которые выдаются в панелях веб-мастера (GSC и Я.Вебмастер)

Ненадежный хостинг

Неверно настроенный sitemap.xml или вообще его отсутствие

Ситуация 5. Очень плохое качество страниц

А бывает и так,что ужаснувшись качеству контента на страницах, поисковик просто откажется выводить вас в сетевые массы. Но это редкость. Чаще - плохая индексация не говорит о том, что лично ваш контент плох. Это говорит о том, что контент ваших конкурентов намного лучше :) И уже в сравнении с ними теряются позиции выдачи.

На что поисковик обращает особое внимание в этой ситуации:

Оригинальность и уникальность контента

Одна и та же структура заголовков, повторные метатеги.

Большое количество страниц 404 (если это про вас, тогда с достоинством выплывайте хотя бы за счет этого )

Тяжелая графика + неоптимизированный контент = низкая скорость загрузки

Мы прошлись по самым основным и распространенным причинам плохого индексирования. По идее, этого должно хватить, но если нет - настраивайтесь на дальнейшие разборки с сайтом уже в компании толкового SEO-специалиста. Удачи!

Запись на курсы

Запись на курс

Комментарии

Добавить комментарий